In Interlogica abbiamo avviato un Proof of Concept (PoC) per esplorare l’integrazione tra intelligenza artificiale e linguaggio naturale nell’analisi dei dati aziendali.

L’obiettivo è superare i limiti delle dashboard tradizionali, rendendo l’accesso alle informazioni più intuitivo e immediato.

Grazie a un’architettura basata su modelli LLM (Large Language Models), il sistema permette di interrogare i database in modo naturale, semplificando la gestione e l’interpretazione dei dati, anche per chi non ha competenze tecniche avanzate.

Vediamo nel dettaglio.

Le dashboard tradizionali sono da sempre strumenti fondamentali nell’analisi dei dati aziendali, ma il loro uso risulta spesso complesso e richiede competenze tecniche specifiche per interpretare correttamente le informazioni.

Questa rigidità, unita alla struttura preconfezionata, può portare a un coinvolgimento ridotto e a una resistenza nell’adozione da parte degli utenti.

Per superare queste criticità, entrano in gioco l’intelligenza artificiale e le query in linguaggio naturale.

In questo modo, le dashboard non si limitano più a visualizzare dati, ma diventano strumenti interattivi capaci di aggregare informazioni da fonti diverse, semplificando processi decisionali e migliorando la gestione complessiva delle informazioni.

Questo metodo si rivela particolarmente vantaggioso in contesti complessi – come il monitoraggio delle performance, la gestione operativa e il controllo strategico – dove l’analisi in tempo reale e la visualizzazione intuitiva favoriscono il riconoscimento di trend emergenti e supportano decisioni rapide e informate, rendendo i dati accessibili anche a chi non possiede competenze tecniche avanzate.

STRUTTURA DELL’ARCHITETTURA LLM

Per garantire un’efficace gestione e interrogazione dei dati, è essenziale adottare un’architettura ben strutturata.

Un sistema basato su modelli LLM è in grado di gestire grandi volumi di dati aziendali in modo organizzato e accessibile.

Questo si traduce in un’infrastruttura che distingue chiaramente le fasi di acquisizione e utilizzo dei dati, ottimizzando il processo di recupero delle informazioni.

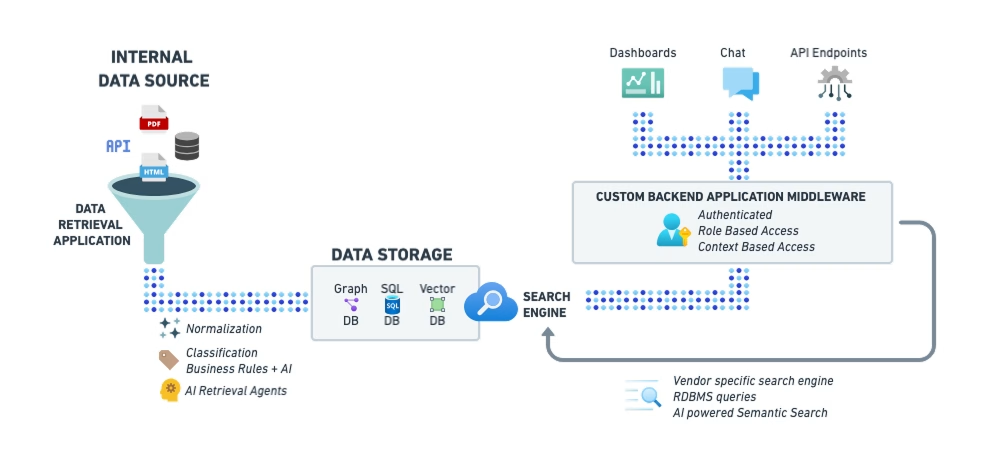

Un’architettura di applicazioni basate su AI generativa si struttura in due parti fondamentali:

- Data Ingestion: raccolta, normalizzazione e classificazione dei dati da diverse fonti aziendali.

- Data Retrieval: interrogazione e recupero delle informazioni tramite sistemi di AI ottimizzati.

L’infrastruttura descritta include tutti gli elementi necessari per attivare diversi casi d’uso di AI in un’azienda strutturata.

Per garantire un’efficace gestione e interrogazione dei dati, è essenziale adottare un’architettura ben strutturata.

1. Sorgenti di Dati (Internal Data Sources)

I dati a disposizione del sistema possono arrivare da fonti interne ed esterne. Possiamo provare a categorizzarle come:

- Dati strutturati (es. database esistenti).

- Dati non strutturati (es. documenti PDF, immagini, file di testo).

- Dati semi-strutturati (es. contenuti estratti da HTML tramite web scraping).

- API di terze parti, che forniscono dati esterni.

2. Applicazioni di Recupero Dati, Normalizzazione e Classificazione

Applicazioni e automazioni specifiche devono essere creati per connettersi alle sorgenti a disposizione per il recupero dei dati. E’ necessario anche un livello di normalizzazione e categorizzazione, oltre che ad una gestione accurata della proprietà e sicurezza di accesso dei dati. Le fasi di questa parte sono:

- AI Retrieval Agents: per la connettività con le sorgenti dati e la logica specifica di recupero

- Normalizzazione: i dati grezzi vengono elaborati per uniformarne il formato e prepararli per l’archiviazione.

- Classificazione con Business Rules + AI: un motore di classificazione arricchisce e categorizza i dati in base a regole aziendali e modelli AI.

3. Archiviazione dei Dati (Data Storage)

Una volta elaborati, i dati devono essere archiviati in un sistema che ne permetta la ricerca e l’uso futuro. Esistono diversi tipi di database, ognuno con uno scopo specifico:

- Vector DB per AI Semantic Search: Database vettoriale per la ricerca AI, è utile quando si vogliono trovare informazioni simili tra loro, ad esempio per ricerche basate sul significato delle parole invece che sulle parole esatte.

Perfetto per le AI che lavorano con il linguaggio naturale. - Database Relazionale (SQL-based): usato per dati strutturati (nomi, numeri, categorie, ecc.)

- Graph Database: specializzato in dati connessi e relazioni tra entità.

4. Motore di Ricerca (Search Engine)

È il sistema che permette di trovare le informazioni giuste tra tutti i dati disponibili.

Funziona in modi diversi:

- Vendor Specific Search Engines: motori di ricerca usati per cercare in grandi quantità di dati testuali.

- RDBMS Queries: il metodo classico, basato su SQL, che permette di fare ricerche precise nei database strutturati.

- AI-powered Semantic Search: un sistema di ricerca semantica avanzata che capisce il significato delle parole, anziché cercare solo corrispondenze esatte.

IL RUOLO DELL’AI NELL’INTERROGAZIONE DEI DATI

L’AI è in grado di tradurre domande testuali in query strutturate.

Ad esempio, si potrebbe chiedere: “Quanti dipendenti lavorano in Interlogica?” e il sistema tradurrebbe automaticamente questa richiesta in una query SQL appropriata.

Il motore di ricerca interpreta quindi i dati e fornisce una risposta comprensibile all’utente.

Questa tecnologia si basa su processi di Text-to-Query e Query-to-Text, permettendo un’interazione più intuitiva e immediata con i database aziendali.

Inoltre, si integra con dashboard e interfacce chat, offrendo contesto e possibilità di drill-down sui dati visualizzati.

VERSO UN’ANALISI PIÙ INTUITIVA

Guardare oltre le dashboard tradizionali significa immaginare un futuro in cui i dati non siano più solo numeri su uno schermo, ma strumenti dinamici di comprensione e decisione.

L’integrazione tra AI e linguaggio naturale apre scenari in cui chiunque, indipendentemente dalle competenze tecniche, può dialogare con le informazioni aziendali in modo diretto e intuitivo.

Non si tratta solo di semplificare l’analisi, ma di trasformarla in un’esperienza più naturale e fluida, in cui le risposte emergono con la stessa immediatezza di una conversazione.

In questo nuovo paradigma, le aziende non si limitano a interpretare i dati: li vivono, li esplorano e li rendono il motore di strategie più consapevoli e reattive.