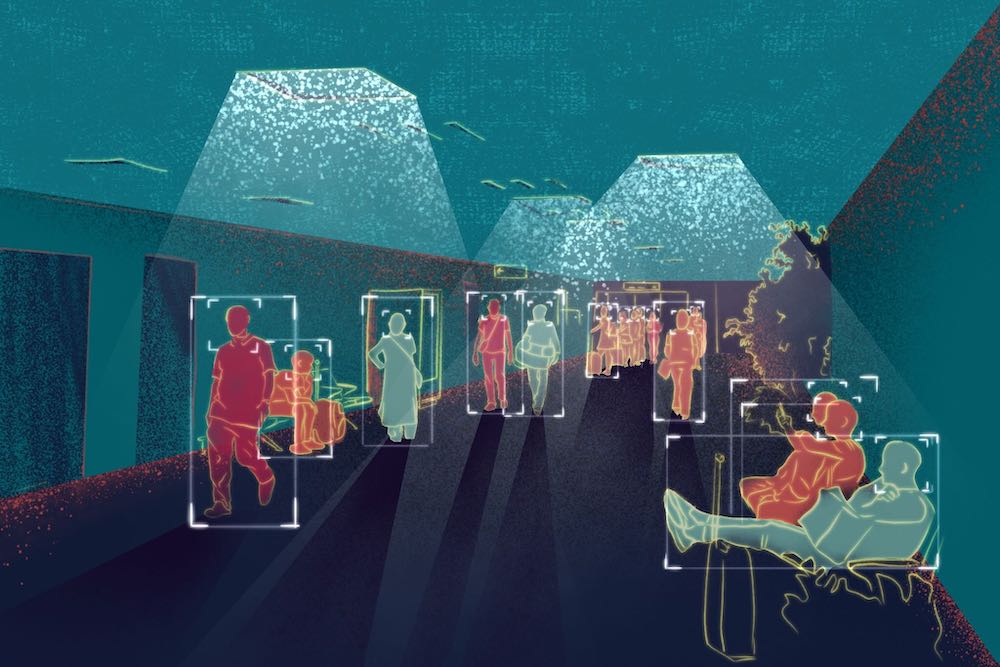

Le tecnologie stanno attraversando, in un lasso di tempo accelerato rispetto al passato, un’immensa evoluzione. Auto a guida autonoma, traduzione istantanea e telefoni cellulari che faranno tutto ciò di cui abbiamo bisogno con un semplice ordine verbale, autonomous things – come droni, robot, navi e apparecchiature – human augmentation, sono solo alcuni degli esempi di Intelligenza Artificiale (IA).

Nella corsa per rimanere competitive capita sovente che le organizzazioni implementino sempre più velocemente nuove tecnologie, spesso senza comprenderne i rischi intrinseci.

Centrale in questo scenario è motivare le organizzazioni ad approfondire la conoscenza dell’IA – come introdurla all’interno dell’azienda e come sfruttarla al meglio – e dei rischi ad essa correlati se non adeguatamente utilizzata.

In risposta alla crescente necessità di sensibilizzazione sui rischi associati all’IA, il World Economic Forum, col Center for the Fourth Industrial Revolution Network Fellows di Accenture, BBVA, IBM e Suntory Holdings, nell’ultimo anno ha lavorato con oltre 100 aziende e esperti di tecnologia per creare l’Empowering AI Toolkit. Si tratta di un framework per valutare i rischi dell’Intelligenza Artificiale, coerentemente agli obiettivi e alle priorità dell’azienda. Non garantisce facili soluzioni, è chiaro, ma dà delle indicazioni concrete al management su come utilizzare in maniera più efficiente l’IA, facilitando la discussione che veicola le decisioni e riducendo la necessità di dover assumere costosi consulenti esterni.

Il toolkit è stato progettato su quattro pilastri, che rappresentano l’impatto dell’IA su aspetti tecnici, organizzativi, di marca e di governance. Il framework supporta quindi le aziende nella decisione delle soluzioni di IA da adottare, negli interventi di marketing e nella comprensione delle potenzialità dell’IA nel far progredire la propria attività.

L’Intelligenza Artificiale promette di risolvere alcuni dei problemi più urgenti che la società deve affrontare: garantire un commercio più equo; ridurre gli sprechi dei consumatori; prevedere le catastrofi naturali; favorire una diagnosi precoce per i malati di cancro, etc. Dietro l’angolo, però, c’è ancora l’ombra degli scandali scoppiati in relazione all’utilizzo non controllato dei dati online e alla violazione della privacy, situazioni che possono danneggiare irreparabilmente anche la fiducia delle persone.

È sufficiente nominare la crisi esplosa nel 2018 che ha coinvolto Cambridge Analytica e Facebook e ha aperto a tutti gli occhi sui rischi connessi ai dati personali in possesso di privati. Il fatto che una società di analisi di Londra, altrimenti sconosciuta, avesse raccolto dati su 50 milioni di utenti del social network senza l’autorizzazione delle persone proprietarie di tali dati, non solo ha suscitato un contraccolpo pubblico, ma ha fatto precipitare il valore di mercato di Facebook bruciando 50 miliardi di dollari entro una settimana dalla scoperta.

A rincarare la dose anche alcune rivelazioni di alto profilo secondo cui alcuni sistemi di IA, utilizzati sia dal governo che dalle imprese, non siano stati controllati adeguatamente e abbiano influenzato negativamente alcune decisioni relative alla vita delle persone. Un caso che ha fatto scalpore è quello di Amazon e del suo programma proprietario di recruiting la cui Intelligenza Artificiale ha distorto le selezioni in base a un bias di razza e/o genere dei candidati.

C’è una certa consapevolezza che le nuove tecnologie possano essere imprevedibili se non utilizzate con attenzione, ma può essere difficile prevedere in anticipo dove/quando si nasconda l’errore.

Permane un atteggiamento diffuso del “a noi non può succedere”, nonostante a volte siano presenti tutti i segnali di avvertimento. La società di customer experience Genesys ha recentemente condotto un’intervista sull’IA su cinquemila datori di lavoro dislocati in sei Paesi diversi, e i risultati hanno evidenziato che il 54% di loro “era tranquillo sull’uso non etico dell’Intelligenza Artificiale nelle loro aziende”.

Essendo in costante espansione, e considerate le immense opportunità a disposizione, l’IA va studiata più che attentamente – in fin dei conti sono soluzioni tecnologiche che usiamo nel quotidiano più di quanto ci piaccia pensare.

Negli ultimi tempi diverse organizzazioni hanno implementato al loro interno gruppi di lavoro sull’IA, commissioni etiche, comitati speciali che si occupano di effettuare consulenze relative alle politiche d’uso, ai rischi e alle strategie da adottare. Un recente sondaggio di KPMG ha rilevato che il 44% delle aziende intervistate afferma di aver redatto un codice etico sull’Intelligenza Artificiale e un altro 30% sostiene di lavorare su uno di essi. Essendo questa una tecnologia emergente, i rischi sono dietro l’angolo e ogni organizzazione dovrebbe dotarsi di una roadmap.

Uno dei maggiori rischi per le aziende di oggi è l’uso di “Inscrutable Black Box Algorithms’”, come li definisce World Economic Forum; in poche parole, la maggior parte degli algoritmi lavora in un modo compreso solo dai programmatori che li hanno sviluppati. Questi algoritmi sono spesso considerati una preziosa proprietà intellettuale, il che rafforza ulteriormente la necessità di mantenere segreti i meccanismi interni, che vengono quindi rimossi dal controllo e dalla governance.

Con l’obiettivo di aiutare ad affrontare correttamente alcuni di questi problemi sono nate no profit come Partnership on AI. Fondata dai giganti della tecnologia Amazon, DeepMind, Facebook, Google, IBM e Microsoft, è stata istituita per trovare le migliori pratiche che possano garantire ai sistemi di IA di essere al servizio della società.

Lo scorso anno, il Belfer Center for Science and International Affairs della Harvard Kennedy School ha convocato la riunione inaugurale del Consiglio dedicata al “Responsible Use of Artificial Intelligence” mettendo allo stesso tavolo le parti interessate di governo, delle imprese, del mondo accademico e della società per esaminare le policy d’uso per l’IA.

Nonostante i molti sforzi, la diffusione e (rapida) evoluzione dell’Intelligenza Artificiale pongono una concreta difficoltà nello stilare delle regole e una definizione dei rischi efficace. Le regolamentazioni dovrebbero pertanto essere adattabili ai cambiamenti e facilmente accessibili; in questo senso, il nuovo Empowering AI Toolkit di WEF è disponibile in maniera totalmente gratuita e potrebbe rivelarsi di immediato valore a livello globale per chi è in procinto di definire le sue policy d’uso.

TI È PIACIUTO QUESTO ARTICOLO? LEGGI ANCHE:

Big Data e Intelligenza Artificiale: Lesson Learned

5G e IoT: la quarta Rivoluzione Industriale

Industry 4.0: meno robot e più people!