Giovedì 22 giugno ero al Milano Convention Center in occasione dell’evento annuale organizzato da Amazon Web Services per promuovere i propri servizi Cloud in continua evoluzione: AWS SUMMIT.

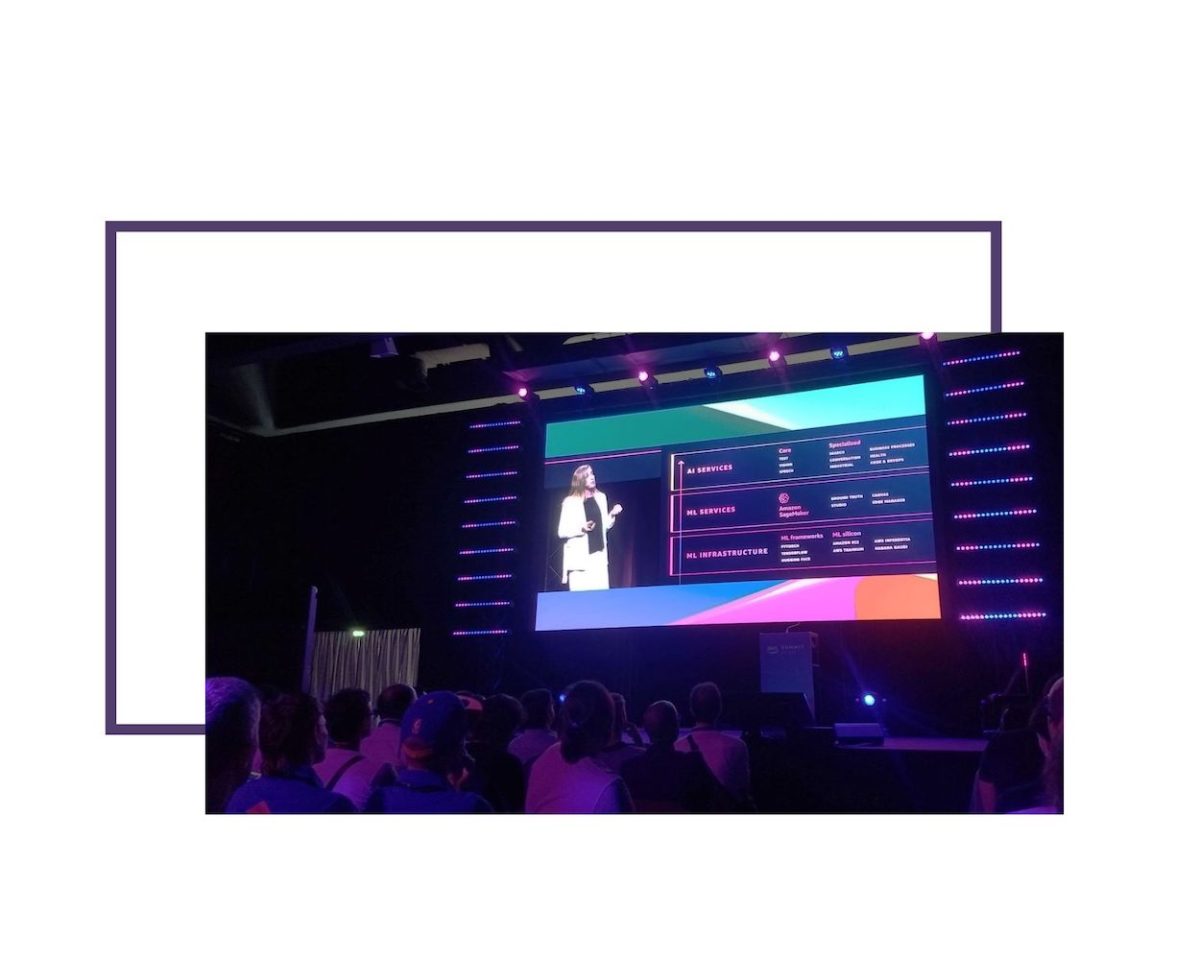

In mezzo a un mare di IoT, di Servitization, di Cloud Computing sopra le nuvole (nello spazio!) e di Supercalcolo, se c’è un servizio che ha dominato la scena è indubbiamente SageMaker, dedicato all’utilizzo di Machine Learning negli ambiti più diversi.

Non si parla più di sperimentazioni, ma di storie di successo, anche se attualmente Gartner stima che il 47% dei progetti ML non riescano ad arrivare dalla fase di Proof Of Concept alla messa in produzione.

È anche vero che in un ambiente Cloud gestito come AWS, la distinzione fra POC e prodotto si assottiglia: se il prototipo dimostra efficacemente la fattibilità, scalare per gestire i carichi di lavoro in produzione è quasi immediato.

Il Keynote di apertura è stato presentato da Holly Mesrobian, VP AWS Serverless Compute, e da Julien Groues, Managing Director AWS France & Italy.

Oltre a una carrellata sulle ultime novità offerte, hanno mostrato alcuni risultati raggiunti da clienti AWS come Infocert che, grazie all’apertura della AWS Region italiana a Milano, ha potuto migrare 2 Petabyte di documenti LegalDoc dall’estero per motivi di compliance normativa.

Fincantieri ha in corso una completa digitalizzazione dei propri cantieri e delle navi che costruisce con l’obiettivo di arrivare a emissioni Net Zero, anche ottimizzando i processi mediante l’utilizzo di calcolo quantistico.

Interessante anche la logistica spaziale di D-Orbit, i cui “furgoncini spaziali” collegati alle Ground Station AWS potranno in futuro servire da “router orbitali” per creare una rete mesh nello spazio con funzioni di Edge Computing per ridurre la banda usata per trasmettere dati dai satelliti a terra.

Tra la grande quantità di talk simultanei disponibili in agenda ho scelto di seguire quelli più attinenti ai progetti sui quali lavoro in Interlogica, che riguardano due mondi che stanno convergendo rapidamente: IoT e Machine Learning.

Negli intervalli tra una sessione e l’altra ho anche potuto esplorare gli spazi espositivi, dove ampio spazio era dedicato a DeepRacer, la gara di automobiline robotiche che vengono addestrate con i dati di chi gioca a un simulatore (training), per poi essere messe alla prova autonomamente su un circuito (inference).

Interessante dimostrazione anche il tavolo da calcetto connesso, dove il video di un semplice smartphone viene processato localmente (on the Edge, senza mandare il video in Cloud) per analizzare mediante Machine Learning i movimenti di giocatori e palla, tenendo il punteggio in tempo reale.

SESSIONI BREAKOUT

INDUSTRIAL IOT E SERVITIZATION SU AWS: L’ESPERIENZA DANIELI TRA PRESENTE E FUTURO

Un tema emergente nell’Industria Manifatturiera è quello della cosiddetta Servitization. Anziché limitarsi a vendere un prodotto, si può utilizzare IoT per farlo in modo continuativo con nuovi servizi collegati ai prodotti stessi – da CapEx (Capital Expenditure è il costo per sviluppare o fornire asset durevoli per il prodotto o il sistema) a OpEx (Operating Expense è il costo necessario per gestire un prodotto).

Uno dei servizi più desiderabili fra quelli resi possibili dalle nuove tecnologie, sia lato Cloud che lato Edge, è la Manutenzione Predittiva.

I dati raccolti mediante strumenti IoT vengono analizzati tramite modelli di Machine Learning per individuare le condizioni che possono portare a un malfunzionamento, prima che questo si verifichi.

Danieli sta introducendo questo concetto nei propri impianti siderurgici, dove ha introdotto Amazon Monitron come sistema end-to-end di monitoraggio, dal sensore di vibrazioni fino all’interfaccia utente che espone le proiezioni prodotte dalla AI.

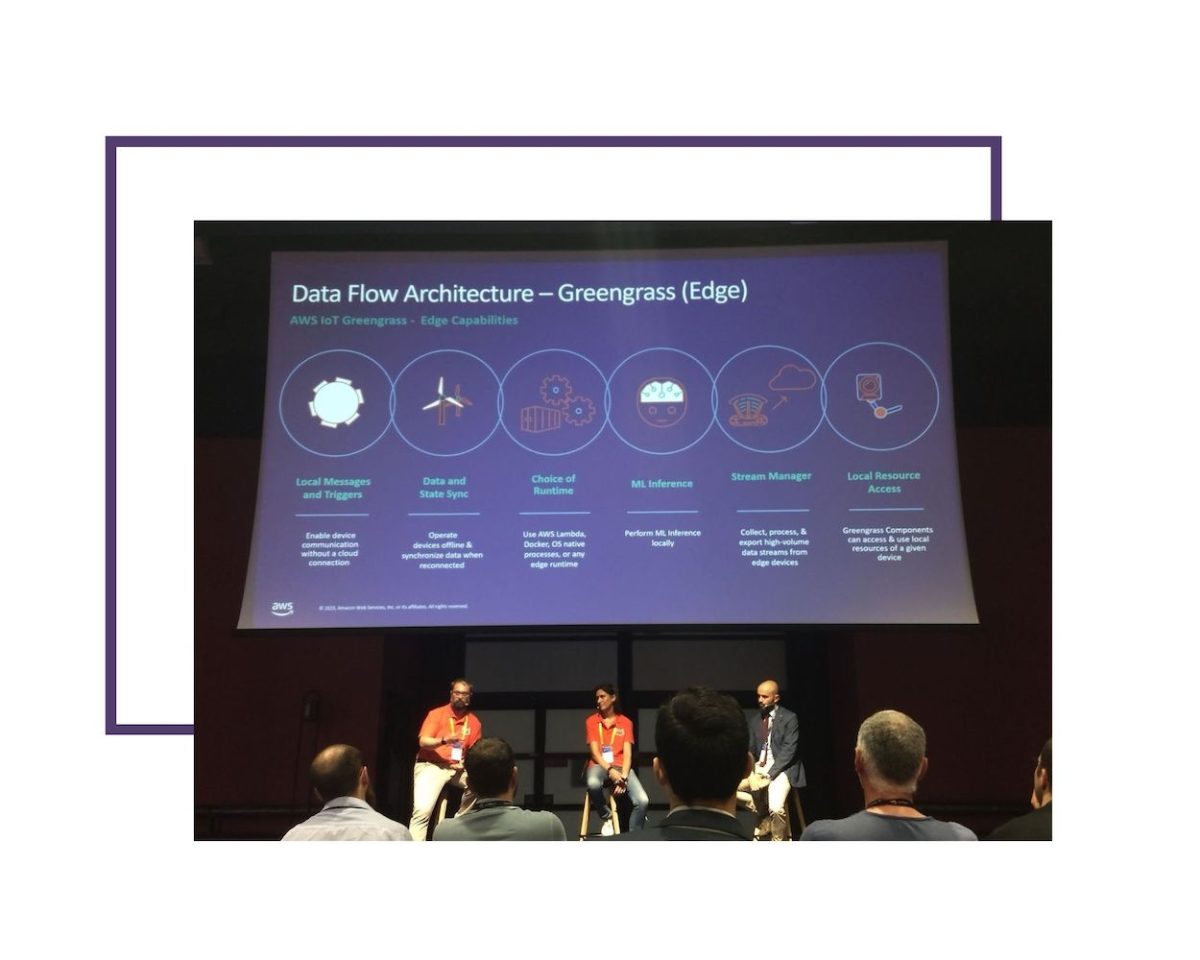

La presenza di AWS Greengrass sia lato Edge (nello stabilimento) che nel Cloud permette di distribuire la pre-elaborazione dei dati (sempre necessaria per la fase di training del ML) in modo ottimale fra i due ambienti, abilitando IoT Sitewise come interfaccia per la raccolta e gestione remota di tutte le informazioni relative agli impianti.

SCOPRIAMO COME SFRUTTARE AL MEGLIO LA POTENZA DELL’AI GENERATIVA

Sessione molto interessante e molto attuale, in un periodo in cui le AI generative come Stable Diffusion, MidJourney e ChatGPT hanno raggiunto la consapevolezza del grande pubblico sollevando un vivace dibattito sul futuro del lavoro e della Società stessa.

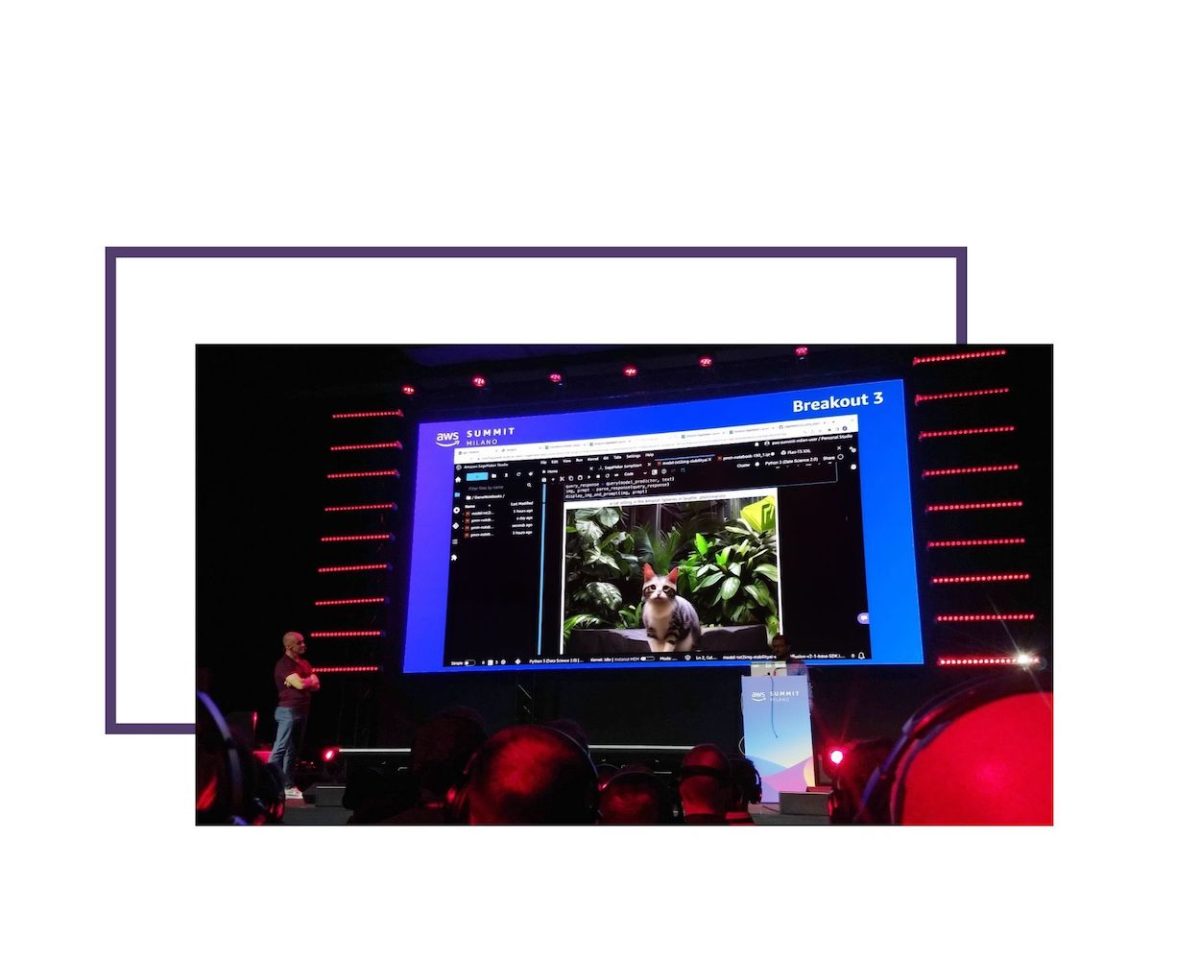

AWS ha mostrato la propria offerta che va dall’hardware dedicato (macchine EC2 Trn1n e Inf2 ottimizzate rispettivamente per il training e per l’inference), ai Foundation Models, pre-addestrati, che si possono applicare a molti domini di dati diversi, alle API Bedrock che mettono un’interfaccia unificata davanti ai diversi modelli (Foundation oppure custom, incluso il famoso generatore di immagini Stable Diffusion), fino alla vera star di tutto il Summit: AWS SageMaker.

In particolare, è stata dimostrata la UI SageMaker Playground e la semplicità con la quale permette di sperimentare a basso costo con diversi modelli fino a produrre soluzioni pronte da portare in produzione.

Interessante anche CodeWhisperer, un suggeritore di codice per sviluppatori, in grado anche di rilevare in tempo reale potenziali vulnerabilità di sicurezza nei sorgenti.

AVVALE: AUTOMATED DEFECT RECOGNITION PER L’INDUSTRIA MANIFATTURIERA

Breve ma interessante presentazione di una soluzione basata su AWS Rekognition per il riconoscimento di difetti nella produzione di tessuti tecnici. Operazione molto lenta e onerosa quando effettuata manualmente, ora automatizzata e notevolmente accelerata grazie a strumenti di Computer Vision basati su Amazon Lookout for Vision.

Un modello ML viene addestrato a trovare i difetti, Rekognition genera le etichette necessarie a distinguerli, e il modello risultante analizza tessuti mentre scorrono a 60 metri al minuto davanti alle telecamere, riconoscendo i difetti con un’accuratezza che va dal 85 al 95%.

HIGH PERFORMANCE COMPUTING INNOVATION WITH FERRARI

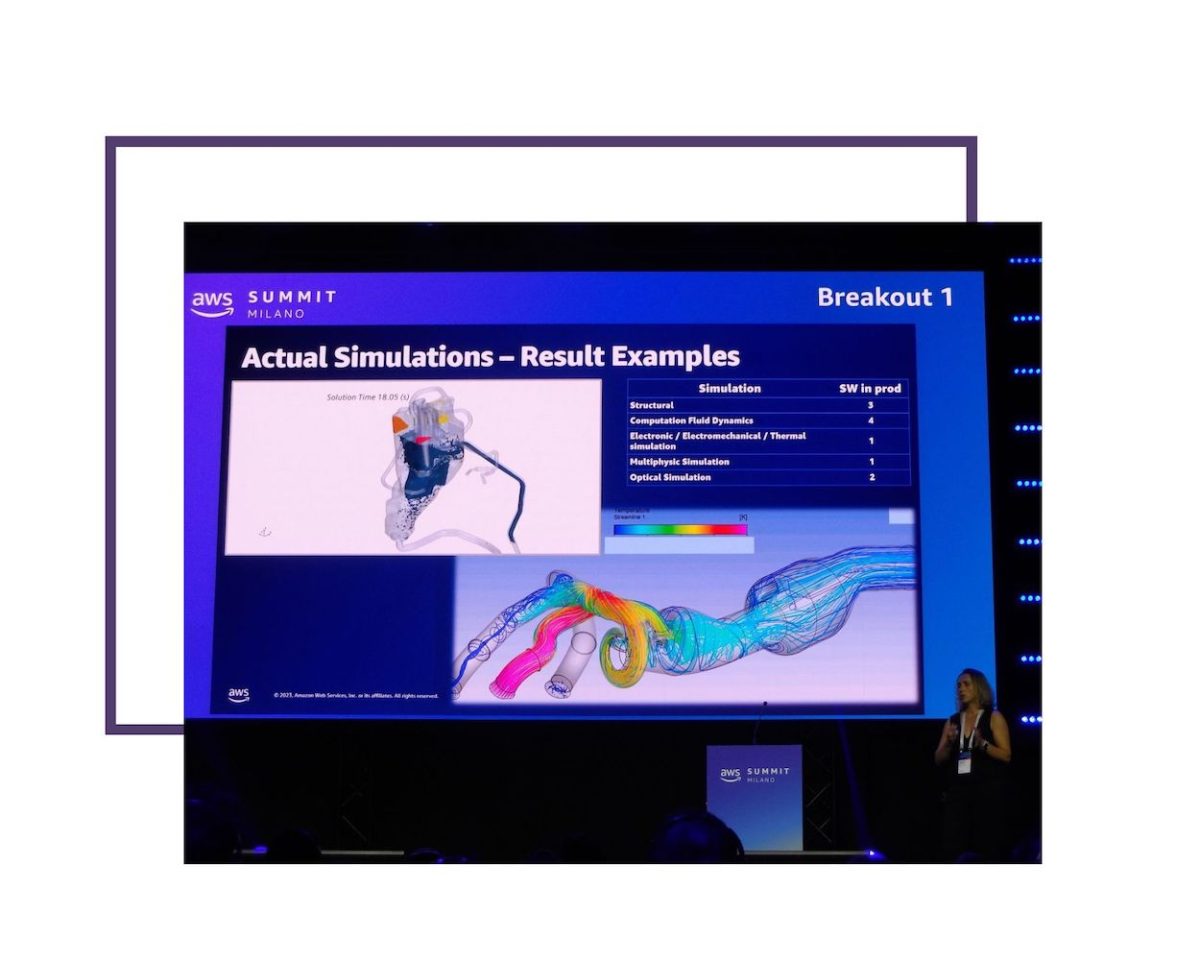

Ferrari ha da sempre a Maranello un centro di supercalcolo (tecnicamente HPC- High Performance Computing) che utilizza nella progettazione delle proprie vetture per calcoli strutturali a elementi finiti, di fluidodinamica, di simulazioni fisiche di diversi generi.

In questa sessione ha mostrato come sia stato possibile far crescere il proprio cluster, che non era più sufficiente per tutti i job (non prevedeva l’uso di GPU, per esempio) e sarebbe stato molto oneroso sostituire, collegandolo mediante Direct Connect a AWS Parallel Cluster per realizzare un’architettura ibrida.

Il cluster su Cloud permette di scegliere fra istanze di macchine EC2 specializzate per carichi di lavoro diversi come Hpc6a (con CPU AMD) per fluidodinamica e meteo, Hpc6id (con CPU Intel) per elementi finiti o sismica, Hpc7g (con CPU Graviton: architettura ARM sviluppata da AWS) per il migliore rapporto prezzo/prestazioni. La piattaforma di virtualizzazione Nitro include un Network layer HW ottimizzato ed eroga prestazioni quasi identiche a quelle ottenibili su hardware fisico. Elastic Fabric Adapter fornisce una matrice di interconnessione fra le componenti che scala quasi linearmente col numero di core.

Le connessioni di rete all’interno del cluster non fanno uso di TCP, ma del protocollo SRD–Scalable Reliable Datagram ottimizzato appositamente.

Anche il sistema di storage, che deve rendere accessibili grandi moli di dati in tempi brevissimi, è ottimizzato ad hoc per il supercalcolo: FSx for Lustre espone un filesystem parallelo ad alte prestazioni su un servizio gestito.

In questa nuova configurazione ibrida, ogni job di simulazione viene valutato in base ai requisiti computazionali e di trasferimento dati e inviato o suddiviso tra le risorse più adeguate tra Maranello e Amazon. I risparmi conseguiti sui tempi di esecuzione vanno dal 30% al 70%, calando all’aumentare del numero di core (ma in modo lineare). Dopo vari benchmark è stata aumentata la banda di rete 4x e portato il numero di core fino a ottenere migliori prestazioni nel 100% degli use case.

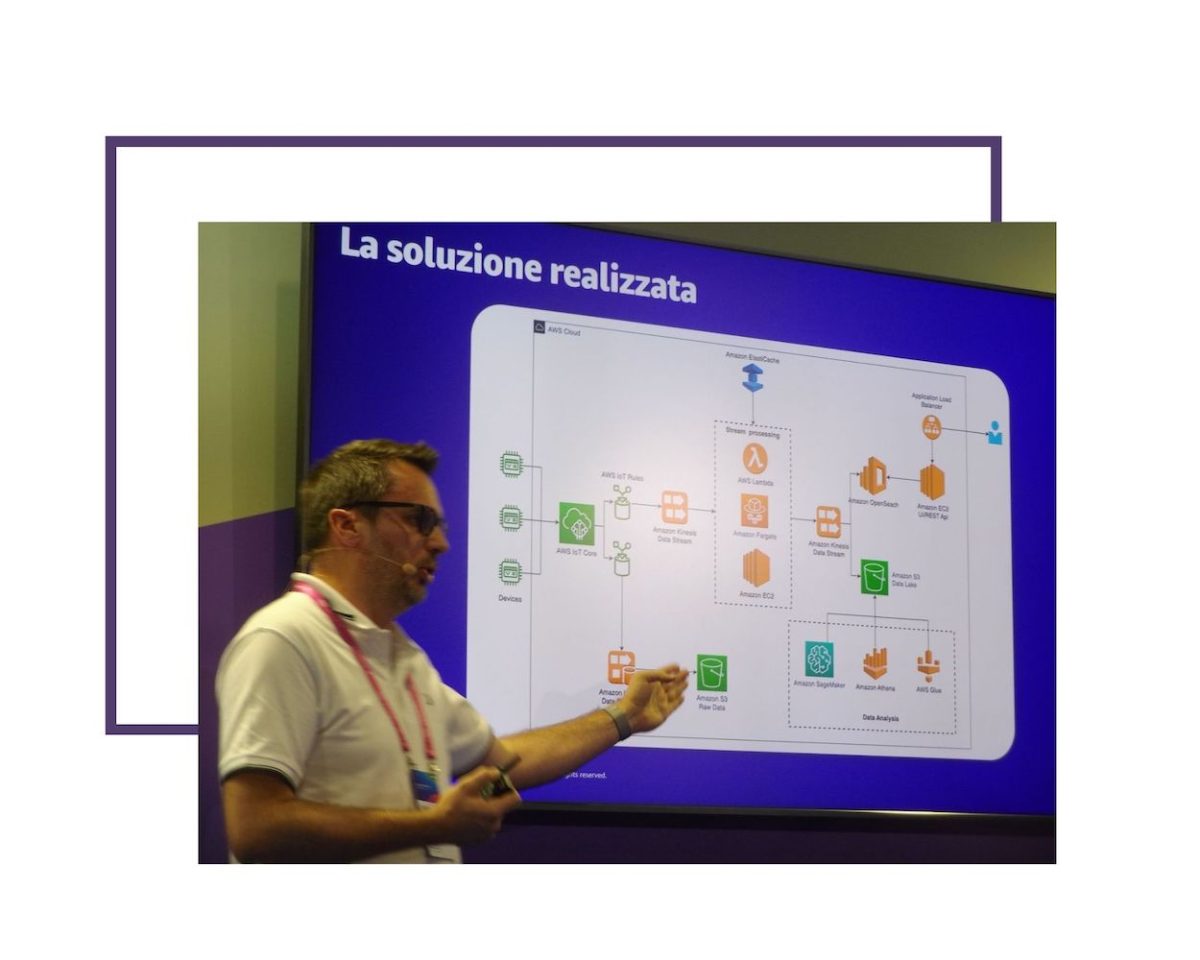

OMNYS, AWS IOT E SAGEMAKER PER IL MANUFACTURING: IL CASO CLIVET

Tornando al tema della Servitizzazione nell’Industria Manifatturiera, Omnys ha tenuto una sessione breve ma intensa su un caso esemplare: l’introduzione del Machine Learning per la Manutenzione Predittiva, l’ottimizzazione e il monitoraggio delle pompe di calore prodotte dal proprio cliente, uno dei leader del settore.

Anche in questo caso l’onnipresente SageMaker è stato inserito nella pipeline IoT basata su Kinesis, attingendo dati normalizzati da un DataLake su Amazon S3. Ogni giorno vengono elaborate 105 milioni di telemetrie da impianti installati in tutto il mondo (45 miliardi quelle già storicizzate) e la previsione dei malfunzionamenti ha raggiunto l’80%.

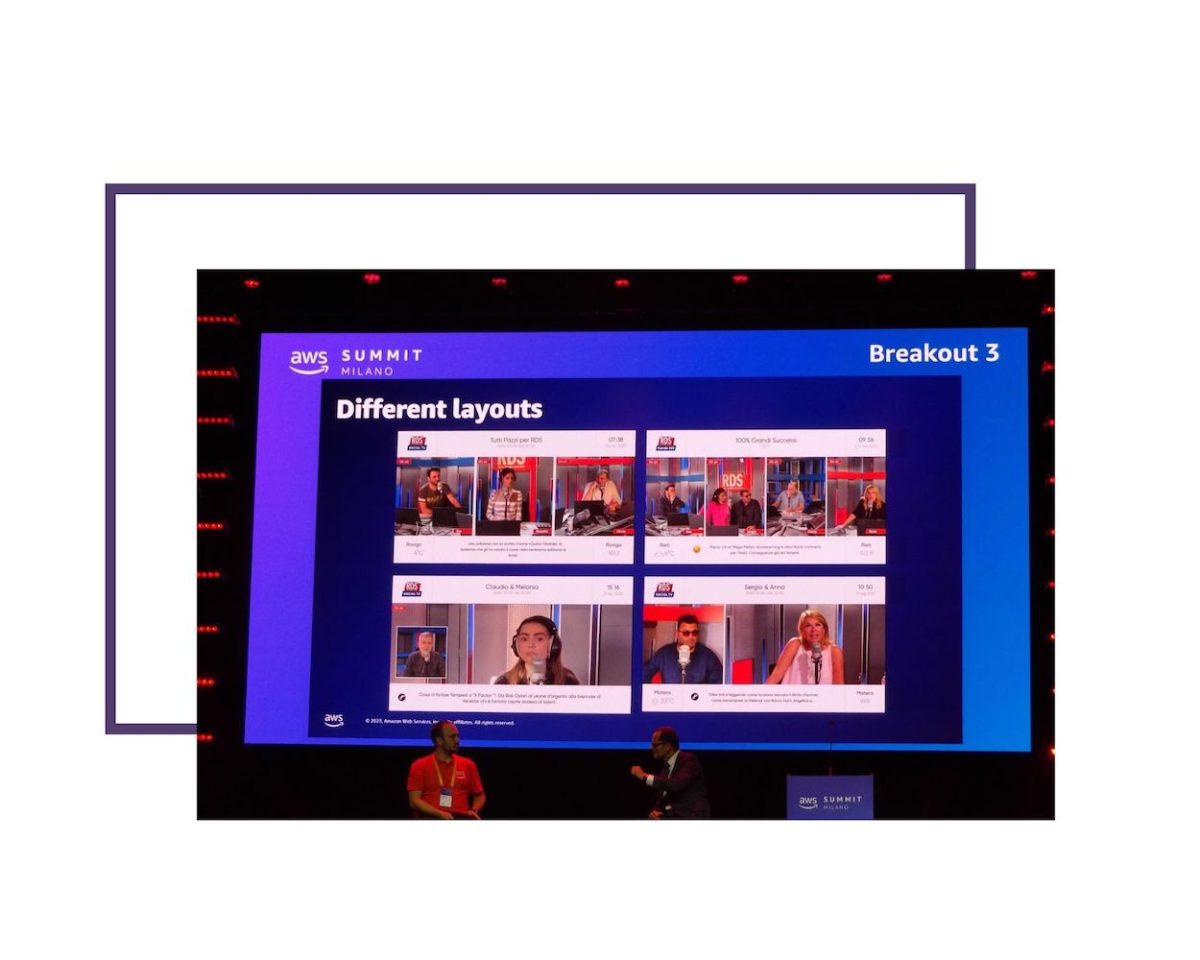

L’INTELLIGENZA ARTIFICIALE COME REGISTA. SCOPRI COME RADIO DIMENSIONE SUONO HA CREATO UN CANALE TV UTILIZZANDO AMAZON REKOGNITION

Radio Dimensione Suono si è trovata a fronteggiare investimenti importanti in attrezzature e personale nel momento in cui ha voluto lanciare la propria SOCIAL TV. Trattandosi di una radio, non disponeva di telecamere, luci, attrezzature video, registi, cameraman, eccetera.

Alla fine non ne ha avuto bisogno perché ha adottato AWS Rekognition come “regista” e due semplici iPhone come telecamere.

Una app iOS sviluppata appositamente invia gli stream video al Cloud, dove i volti vengono localizzati e riconosciuti, il parlato trascritto, le inquadrature adattate automaticamente in base a ciò che succede.

Oltre ai risparmi conseguiti, questo permette anche una stretta integrazione con i Social Network, consentendo di includere in modo trasparente nelle decisioni della “regia” anche stream provenienti da ospiti remoti e di moderare automaticamente i commenti provenienti dai social.

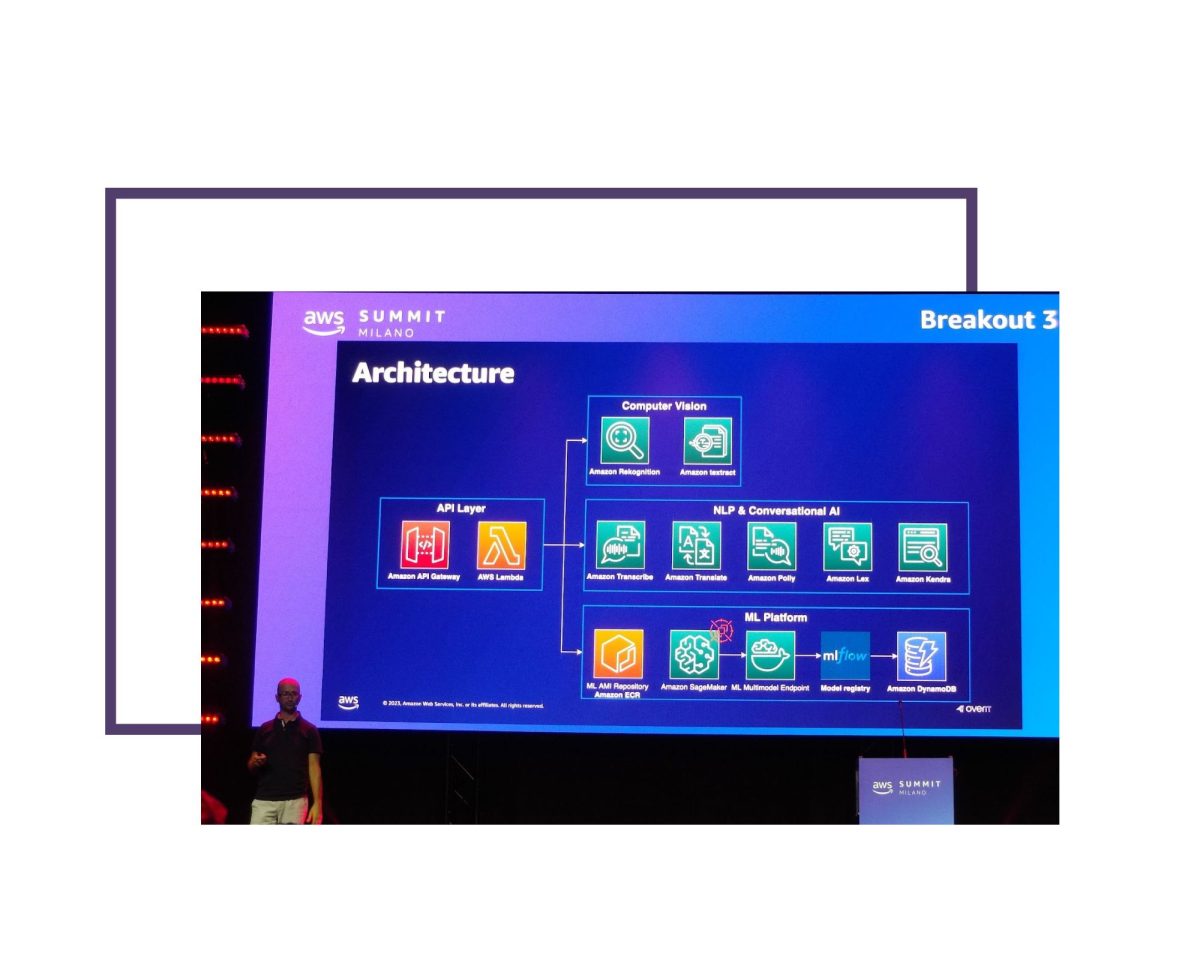

COME OTTIMIZZARE PROCESSI INDUSTRIALI E MANUTENZIONE DI IMPIANTI CREANDO MODELLI DI MACHINE LEARNING CON AMAZON SAGEMAKER

L’ultima sessione che ho seguito ha portato altri due esempi di come il Machine Learning viene utilizzato al servizio della Digital Transformation nell’industria.

OverIT ha cominciato a trasferire il proprio vasto know how nel Field Service Management (supporto sul campo) dalle tradizionali tecniche di Ricerca Operativa a modelli ML basati su SageMaker.

L’obiettivo, anche in questo caso, è quello di addestrare modelli AI per abilitare servizi di Manutenzione Predittiva che permettano di intervenire sul campo prima ancora che il problema si verifichi.

Interessante il caso d’uso dell’automazione dei debriefing degli interventi: grazie a servizi gestiti come Rekognition (acquisizione di documenti cartacei), Transcribe (riconoscimento vocale), Translate (traduzione) e Polly (sintesi vocale) il processo può avvenire a voce, senza occupare le mani dell’operatore, in qualunque lingua, eventualmente con l’ausilio di visori a realtà aumentata.

Anche Prima Industrie ha utilizzato SageMaker per abilitare la Manutenzione Predittiva dei propri macchinari per il taglio laser dei metalli. L’analisi del video degli apparecchi in funzione permette di rilevare un eventuale degrado delle prestazioni.

Dovendo scegliere nella fase di training del modello fra la modalità supervisionata (con operatore umano che classifica gli input) oppure non supervisionata (con rilevamento automatico degli scostamenti), ha provato entrambi gli approcci raggiungendo risultati simili.

Ha quindi optato per il non supervisionato, in modo da poter effettuare un addestramento continuo del modello che permetta di farne crescere l’accuratezza nel tempo, man mano che i macchinari inviano nuovi dati (mezzo milione di telemetrie alla settimana per ogni macchina).

Al momento di scegliere se usare il modello (applicare l’inference) sul Cloud oppure sul Field, bilanciando la scalabilità illimitata del primo con il minore utilizzo di banda del secondo, l’adozione di GreenGrass in entrambi gli ambiti ha permesso di non dover scegliere. I macchinari sono così in grado di autodiagnosticarsi facendo uso di un modello che diventa sempre più accurato.

CONCLUSIONI

Oltre a ciò su cui mi sono focalizzato, l’AWS Summit comprendeva molto altro di interessante sia sul piano operativo che di business. Indipendentemente dalle mie scelte, comunque, il programma complessivo degli eventi evidenziava in modo chiarissimo il peso crescente che l’Artificial Intelligence sta assumendo in tutti i campi, dall’industria all’intrattenimento ad altro ancora.

E probabilmente le applicazioni che ci cambieranno la vita dobbiamo ancora vederle nascere.

TI È PIACIUTO QUESTO ARTICOLO? LEGGI ANCHE:

Un passo nel futuro: Virtual Reality e Augmented Reality

Etica e Intelligenza Artificiale: due parole con Valter Fraccaro

Big Data e Intelligenza Artificiale: lesson learned